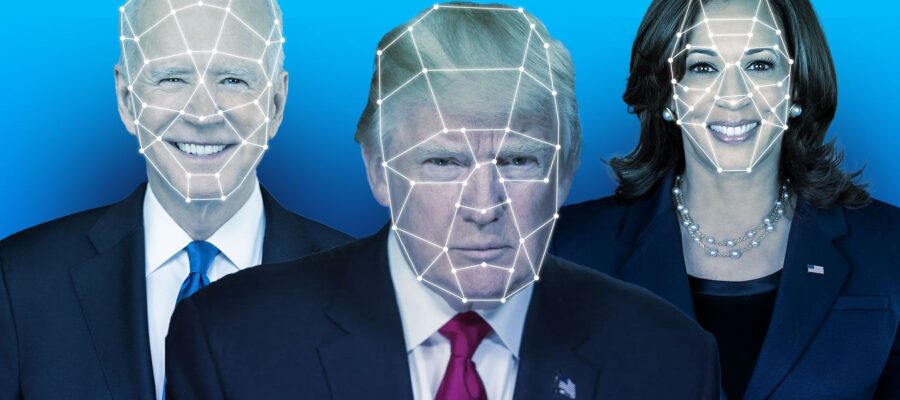

Цьогорічний передвиборчий сезон у США, без сумніву, був цікавим. Класичні елементи перегонів – звинувачення та словесні напади один на одного між кандидатами доповнилися технологічними інструментами. Зокрема, штучним інтелектом, який використовували для створення мемів та діпфейків.

Через чат-бот Grok від Ілона Маска у X запускали безліч згенерованих мемів – від Барака Обами, який вживає кокаїн, Дональда Трампа з вагітною жінкою, яка віддалено нагадує Камалу Гарріс, і до Трампа та Гарріс, які тримають пістолети. Використовували й більш небезпечний елемент – діпфейки, згенеровані відео з відомими персонами, які важко відрізнити від реальних роликів.

24 Канал розповідає, чиї діпфейки використовувалися у президентських перегонах у США та як ними намагалися втрутитися у волевиявлення американців.

Діпфейки від ChatGPT

Під час виборчої кампанії багато користувачів намагалися скористатися генератором зображень DALL-E від OpenAI для створення діпфейків, але компанія повідомила про успішне запобігання цим спробам.

За даними нового звіту, ChatGPT відмовився виконати понад 250 000 запитів на створення зображень із президентом Байденом, обраним президентом Трампом, віцепрезиденткою Гарріс, обраним віцепрезидентом Венсом і губернатором Волзом.

OpenAI пояснила, що це стало можливим завдяки раніше впровадженим заходам безпеки, які блокують створення зображень із реальними людьми, включаючи політиків.

OpenAI розпочала підготовку до виборів ще на початку року, розробивши стратегію для запобігання поширенню дезінформації через свої інструменти. Компанія гарантувала, що користувачі, які запитували ChatGPT про процес голосування у США, будуть перенаправлені на сайт CanIVote.org. За місяць до виборів чат-бот забезпечив 1 мільйон таких перенаправлень.

У день виборів і наступного дня ChatGPT надав 2 мільйони відповідей, скеровуючи користувачів до перевірених джерел, як-от Associated Press та Reuters, для отримання офіційних результатів. OpenAI також запобігла можливості вираження будь-яких політичних уподобань чи рекомендацій кандидатів з боку ChatGPT, навіть якщо цього вимагали запитувачі.

Однак DALL-E – не єдиний генератор зображень на базі штучного інтелекту, і в соціальних мережах все одно з’являлися діпфейки, пов’язані з виборами.

Наприклад, одне зі змінених відео зображало Камалу Гарріс, де вона нібито стверджувала, що її обрали як «найкращий варіант для забезпечення різноманітності». Допис з цим відео поширив Ілон Маск, в результаті чого він набрав понад 136 мільйонів переглядів.

This is amazing

pic.twitter.com/KpnBKGUUwn

— Elon Musk (@elonmusk) July 26, 2024

Яким був вплив штучного інтелекту на вибори у США

ШІ не вплинув на вибори, але поглибив розкол між республіканцями та демократами, пише The Washington Post. Однак похмурі прогнози про те, що ШІ зірве вибори, не виправдалися.

Фахівці по всій Америці – від Вашингтону до Каліфорнії – протягом двох років перед виборами попереджували, що швидкий прогрес ШІ посилить дезінформацію, пропаганду та мову ворожнечі. І зрештою це вплине на результати президентських виборів.

У звіті Інституту стратегічного діалогу (ISD) виявили, що швидке зростання кількості контенту, створеного штучним інтелектом, створило «цілковито забруднену інформаційну екосистему», в якій виборцям все важче розрізняти штучне від справжнього.

Експерти вважають, що до часу вступу на посаду Трампа, середовище соцмереж, особливо X, сприятиме згуртуванню його прихильників. Зокрема, у важких питаннях на кшталт масових депортацій мігрантів чи заборони абортів. Створені штучним інтелектом фейки можуть допомогти інфлюенсерам поширювати в соцмережах неправдиві наративи та зміцнювати партійні переконання мільйонів людей. Відсутність модерації ШІ-контенту лише полегшить цю справу.

Серед уже помітних діпфейків – підробка голосу президента Байдена в спробі перешкодити виборцям Нью-Гемпширу брати участь у праймериз у штаті. Оперативник від Демократичної партії, який стверджував, що намагався підвищити обізнаність про небезпеку штучного інтелекту, був оштрафований Федеральною комісією зв’язку на 6 мільйонів доларів через порушення правил телекомунікацій.

https://s3.eu-central-1.amazonaws.com/media.my.ua/feed/52/2f79d0529cc80fa70016a0ada34fd903.jpg

Камала Гарріс / Фото Susan Walsh / AP

Також у поширених фейках використовували такі наративи:

карикатурні зображення Трампа в нацистській формі; зображення Камали Гарріс в сексуальних позах; підроблені фото натовпів темношкірих людей, які нібито підтримують Трампа, – це демографічна група виборців до якої «залицялися» обидві партії.

Попри те, що в більш ніж десяти штатах діють закони, які карають за використання штучного інтелекту для створення оманливих відео про політиків, модерація такого контенту майже не здійснювалася. Це виявило прогалини в застосуванні як законодавства, так і політик соціальних мереж. Набір програм для виявлення діпфейків, створених штучним інтелектом, не виправдав покладених на нього очікувань. У результаті основний тягар ідентифікації підроблених зображень та аудіо в соцмережах ліг на випадкову систему фактчекінгу та дослідників у провідних медіа.

ІПСО з-за океану широко використовували ШІ для вкидів про фальсифікації та про заклики українського президента Володимира Зеленського голосувати за Гарріс. Такі випадки зафіксувала організація NewsGuard, що займається моніторингом дезінформації.

Однак, попри поширення ШІ-технологій, немає доказів, що таке втручання суттєво вплинуло на виборчий процес, каже Джен Істерлі, директорка Агентства з кібербезпеки та безпеки інфраструктури, яке відповідає за захист виборчої інфраструктури. Дослідники виявили лише кілька випадків використання ШІ для створення дезінформації щодо процесу голосування, підтвердила Кейт Старберд, співзасновниця Центру інформованої громадськості Вашингтонського університету, на брифінгу для ЗМІ. Вона додала, що більшість чуток базувалися на неправильному тлумаченні реальних фактів, а не на повністю вигаданих історіях.

Подібна ситуація спостерігалася й за кордоном. Штучний інтелект не мав значного впливу на вибори у Великій Британії та Європейському Союзі, згідно зі звітом Інституту Алана Тюрінга.

За словами дослідників, під час загальних виборів у Британії було зафіксовано лише 16 підтверджених випадків вірусної дезінформації або дипфейків, тоді як в ЄС – лише 11, включно з виборами у Франції.

Однак ШІ все ж вплинув на громадську думку. Ультраправі групи масово поширювали дезінформацію, створену за допомогою ШІ, на X. Серед контенту був такий:

віральні зображення дітей, постраждалих від урагану; теорії змови та антисемітські напади на чиновників адміністрації Байдена; дипфейк Трампа, де голос обраного президента нібито погрожував убити прем’єр-міністра Канади Джастіна Трюдо.

Трампісти ж використали згенеровані зображення фанатів Тейлор Свіфт, які нібито підтримували Трампа, що викликало публічну реакцію співачки на користь Гарріс.

WP наводить прогноз експертів, що використання штучного інтелекту для дезінформації у майбутньому лише посилиться, ускладнюючи процес факчекінгу та підриваючи довіру до правдивих джерел інформації.

На кого були націлені діпфейки

Під час аналізу 582 політичних фейків, що з’явилися під час президентської виборчої кампанії, дослідники з Університету Пердью виявили, що 33% з них стосувалися Дональда Трампа, пише WP. Приблизно 16% були зосереджені на Камалі Гарріс і стільки ж – на Джо Байдені. Цей контент представляв кандидатів як у позитивному, так і в негативному світлі.

Згідно з даними дослідниці Крістіни Вокер з Університету Пердью, близько 40% цих фейків були створені для «сатиричних цілей».

Ще 35% поширювалися випадковими користувачами з незначною кількістю підписників, тоді як лише 8% були опубліковані акаунтами з понад 100 000 підписників.

За словами Кейлін Джексон Шифф, доцентки кафедри політології Університету Пердью, ці створені ШІ меми провокували людей гуртуватись у спільноти. Наприклад, прихильники Трампа активно обговорювали випадок із «білочкою Пінат» – нібито незаконним домашнім улюбленцем, якого конфіскували та приспали напередодні дня виборів.

Такі фейки допомагають виборцям формувати позитивне ставлення або розуміння подій, навіть якщо вони не вірять, що зображення є справжнім,

– пояснює Шифф.

Що відомо про білку Пінат Пінат стала улюбленицею соцмереж після того, як її сім років тому прихистив Марк Лонго з Пайн-Сіті у Нью-Йорку. Він публікував відео та фото з білкою, яка їла вафлі та носила капелюшки. Однак Лонго не мав дозволу на утримання дикої тварини, хоча, за його словами, він працював над отриманням необхідних документів. Наприкінці жовтня інспектори провели обшук у його домі, вилучивши Пінат та єнота, на ім’я Фред. За даними нью-йоркського департаменту екології, рішення конфіскувати тварин було ухвалено після численних скарг від місцевих мешканців.

Через кілька днів Пінат і Фреда приспали для перевірки на сказ, після того як білка вкусила одного з інспекторів. Тестування на сказ вимагає дослідження мозкової тканини, тому тварин довелося вбити, хоча білки майже ніколи не переносять сказ. Інцидент викликав хвилю обурення, особливо серед консерваторів, які розцінили це як приклад надмірного державного втручання. Кампанія Дональда Трампа навіть пообіцяла «помститися за Пінат» на виборах. За даними The New York Times, гнівна реакція мала не менше 10 анонімних погроз вибуху на адресу державних установ.

Однак експерти попереджають, що штучний інтелект спричинив суттєву шкоду, створюючи сумніви щодо реальності та змушуючи людей загалом ставити під питання правдивість інформації. Дослідники Інституту стратегічного діалогу (ISD) проаналізували понад мільйон дописів на X, YouTube та Reddit, які містили ШІ-контент, пов’язаний з виборами, і виявили, що соцмережі часто не встигають маркувати або видаляти такий контент, навіть якщо він був спростований.

Дослідження показало, що користувачі неправильно оцінюють, чи був контент створений ШІ, у 52% випадків. Найчастіше люди помилково сприймали справжній контент як штучний, ніж навпаки.

Багато з помилкових оцінок базувалися на застарілих припущеннях про те, як розпізнати ШІ-контент. Навіть інструменти для виявлення ШІ виявилися неефективними: їх часто використовували або невірно інтерпретували, що призводило до хибних висновків. Крім того, 44.8% постів зі згадками про ШІ під час виборів натякали, що інша сторона постійно використовує штучний інтелект, через що їй не можна довіряти. Деякі користувачі висловлювали занепокоєння, що ШІ змушує їх сумніватися у всьому.

Що відомо про протрампівську ботоферму

У соцмережі X набули поширення акаунти, які використовують генеративний штучний інтелект для підтримки Дональда Трампа, повідомила на своїй сторінці в X OSINT-дослідниця дезінформації Еліс Томас. Вона спеціалізується на дослідженні інформаційних операцій, теорій змови та політичних рухів в інтернеті.

Occasionally they post refusals, although it happens rarely enough that whoever built the network has clearly found a way around @OpenAI’s safeguards which works fairly well. pic.twitter.com/7LYUuBe95m

— Elise Thomas (@elisethoma5) November 3, 2024

Томас виявила кілька десятків акаунтів, деякі з яких мали синю галочку верифікації, що є типовим для мереж ботоферм. Ці акаунти часто видають себе за ботів, використовуючи старі хештеги на кшталт #Trump2020 або навіть відкрито заявляючи: «Я мовна модель ШІ, створена OpenAI».

За словами Томас, вона помітила акаунти, що конфліктували самі з собою або суперечили дезінформації, яку поширював Ілон Маск. Це свідчить про те, що творці ботів знайшли спосіб обходити захисні механізми OpenAI, хоча не завжди успішно. Деякі акаунти діяли як «центральні вузли», поширюючи контент, який потім підхоплювали інші боти для збільшення охоплення.

Еліс Томас передала ці акаунти для подальшого розслідування OpenAI, і платформа X швидко їх видалила. Проте поки невідомо, хто саме стоїть за цією мережею. Томас підкреслила, що ШІ суттєво ускладнює ідентифікацію відповідальних за такі кампанії, оскільки все може бути повністю автоматизованим, навіть без участі людей.

Це не перший випадок використання ШІ-мереж для впливу на вибори у США. Дослідники Клемсонського університету раніше виявили 686 акаунтів, які використовували великі мовні моделі для створення правдоподібного контенту. Тим часом користувачі соцмереж самостійно розкривають боти, змушуючи їх виконувати інші завдання – наприклад, писати вірші.

Хоча досі не видно значного впливу цих мереж на думки реальних виборців, експерти попереджають: зі зростанням потужності ШІ, виявляти подібні боти стане складніше.